In den vergangenen Jahren hat sich die Welt der künstlichen Intelligenz (KI) rasant entwickelt. Ein besonders grosses Interesse gilt dabei den sogenannten Large Language Models (LLMs), wie etwa ChatGPT, die in der Lage sind, menschenähnliche Texte zu verfassen. Doch wie funktioniert diese Technologie genau, und warum hat sie sich so schnell verbreitet? Ein genauerer Blick auf die Mechanismen der LLMs zeigt, wie sie arbeiten, welche Herausforderungen es gibt und wie sie sich von anderen Arten von Künstlicher Intelligenz unterscheiden.

Wie LLMs lernen: Ein Blick hinter die Kulissen

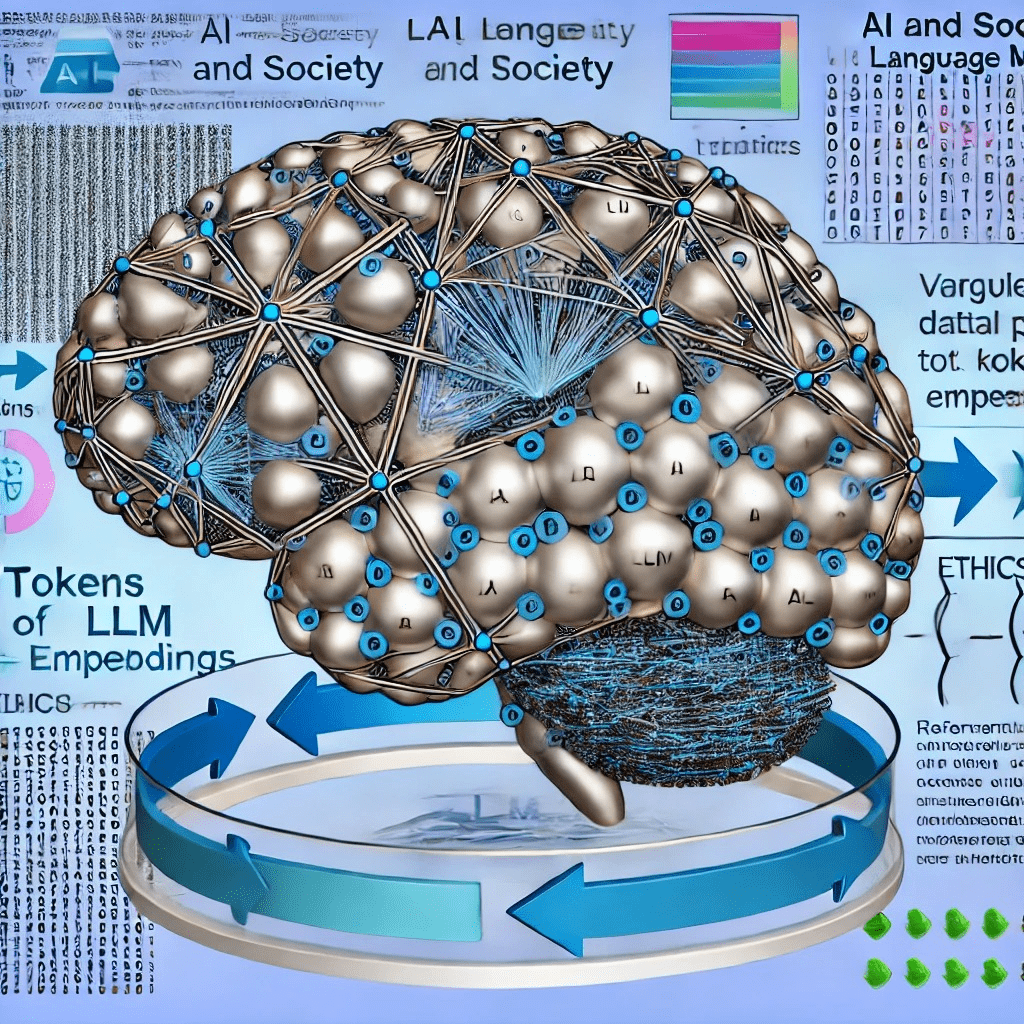

LLMs basieren auf der Idee, Sprache in eine mathematische Form zu übersetzen, um sie besser verarbeiten zu können. Dazu wird der Text in viele kleine Einheiten, sogenannte „Tokens“, zerlegt. Ein Token kann ein ganzes Wort, ein Wortteil oder sogar ein einzelnes Zeichen sein. Dieser Prozess der „Tokenisierung“ ist entscheidend, da das Modell die Wörter nicht direkt „versteht“, sondern als Zahlenreihen verarbeitet. Diese Zahlen können als Koordinaten in einem mehrdimensionalen Raum betrachtet werden, was es dem Modell ermöglicht, die Beziehung zwischen verschiedenen Tokens zu erkennen.Das Training eines LLMs ist enorm datenintensiv. Typischerweise werden Milliarden von Wörtern aus dem Internet, Büchern, wissenschaftlichen Artikeln und anderen Textquellen eingespeist. Dabei versucht das Modell, Muster in diesen Daten zu erkennen und zu lernen, welches Wort auf ein anderes folgen könnte. Dieser Prozess ist vergleichbar mit einem Kind, das eine Sprache erlernt, indem es zuhört und aus der Vielzahl der gehörten Sätze Muster ableitet. Doch anders als beim menschlichen Lernen erfolgt dies bei einem LLM in gigantischem Maßstab und mit der Präzision der Mathematik.

Das Geheimnis der „Embeddings“: Bedeutung als Zahlenstruktur

Eine Schlüsselkomponente in der Funktionsweise von LLMs sind die sogenannten „Embeddings“. Diese dienen dazu, den semantischen Inhalt der Tokens, also ihre Bedeutung, in Zahlenform zu erfassen. Jedes Token wird in einem hochdimensionalen Raum dargestellt, in dem ähnliche Tokens näher beieinanderliegen. Ein einfaches Beispiel: Wörter wie „Katze“ und „Hund“ würden im Raum näher zusammenliegen, da sie beide Haustiere beschreiben, während „Auto“ weiter entfernt wäre. Dieser semantische Raum erlaubt es dem Modell, ein gewisses Verständnis von Bedeutungen und Zusammenhängen zwischen Wörtern zu entwickeln, ohne jedoch eine „echte“ Bedeutung im menschlichen Sinne zu erfassen.Kein Speicher, sondern Wahrscheinlichkeitsmaschinen

Ein weit verbreiteter Irrtum über LLMs ist die Annahme, sie seien eine Art Datenbank, die auf gespeicherte Fakten zugreifen kann. In Wirklichkeit sind sie jedoch komprimierte Wahrscheinlichkeitsmodelle. LLMs speichern nicht die vollständigen Trainingsdaten, sondern lernen Muster und Beziehungen zwischen den Tokens. Sie haben keine detaillierte Erinnerung an einzelne Fakten, sondern generieren auf Basis der Wahrscheinlichkeiten, welches Wort am ehesten auf ein anderes folgt, neue Texte. Es ist vergleichbar mit einem Gedächtnis, das nur grobe Eindrücke behält und daraus plausible Zusammenhänge ableitet.Dies führt zu einem Phänomen, das als „Halluzinationen“ bekannt ist: Da das Modell nicht auf eine exakte Datenbank zugreifen kann, sondern nur auf die von ihm erkannten Muster, kann es in manchen Fällen Informationen „erfinden“. Das LLM versucht dabei, eine schlüssige Antwort zu generieren, auch wenn es keine exakten Informationen in seinen Trainingsdaten dazu hat. Das macht LLMs weniger zuverlässig für Fakten, aber beeindruckend in ihrer Fähigkeit, kreative und sprachlich vielfältige Antworten zu erzeugen.

Verstärkung durch menschliches Feedback

Um die Qualität der Antworten zu verbessern, greifen Entwickler auf eine Methode zurück, die als „Reinforcement Learning from Human Feedback“ (RLHF) bekannt ist. Dabei werden dem Modell verschiedene Antwortmöglichkeiten vorgelegt, und menschliche Tester bewerten diese nach ihrer Qualität. Das LLM lernt so, welche Antworten den Nutzern am meisten zusagen. Dieser Prozess war entscheidend für den Erfolg von Modellen wie ChatGPT, da er dazu führte, dass die Antworten besser den Erwartungen der Nutzer entsprachen.Durch diese Methode wurde auch die Benutzerfreundlichkeit verbessert. Statt komplizierter Entwicklertools wie dem „Playground“ gab es plötzlich eine einfache, intuitive Chatoberfläche, die Millionen Menschen ohne technische Vorkenntnisse nutzen konnten. Das machte LLMs für breite Bevölkerungsschichten zugänglich und trug maßgeblich zu ihrem Erfolg bei.

Grenzen und Potenzial: Was LLMs nicht können

Trotz ihrer beeindruckenden Fähigkeiten haben LLMs klare Grenzen. Ein häufiges Missverständnis ist die Annahme, dass LLMs kontinuierlich aus den Interaktionen mit Nutzern lernen. In Wirklichkeit sind sie statisch, bis ein neues Modell veröffentlicht wird, das dann mit frischen Trainingsdaten ausgestattet ist. Feedback von Nutzern fließt also nicht unmittelbar in die Antworten ein, sondern erst, wenn ein neues Modell trainiert wird.LLMs sind zudem nicht deterministisch, was bedeutet, dass sie auf dieselbe Anfrage unterschiedliche Antworten geben können. Diese Variation ergibt sich aus der internen Wahrscheinlichkeitsverteilung, die das Modell bei der Generierung der Antworten nutzt. Auch das macht LLMs in bestimmten Anwendungsszenarien, wie etwa in der juristischen Beratung oder in sicherheitskritischen Bereichen, unberechenbar.

Warum LLMs die KI-Revolution vorantreiben

Der schnelle Erfolg von LLMs ist nicht nur ein Ergebnis der technologischen Fortschritte, sondern auch der verbesserten Zugänglichkeit und Benutzerfreundlichkeit. Unternehmen wie OpenAI, Google und Meta investieren Milliarden in die Weiterentwicklung dieser Modelle. Sie erkennen das Potenzial der LLMs, den Zugang zu Wissen zu demokratisieren und neue Formen der menschlichen Interaktion mit Maschinen zu ermöglichen.Gleichzeitig bleibt die Debatte um ethische Fragen, wie etwa die Kontrolle von Voreingenommenheit (Bias) und die Sicherstellung von Datenschutz, eine zentrale Herausforderung. Denn während LLMs durch ihre vielfältigen Datenquellen einen breiten Blick auf die Welt haben, spiegeln sie auch die gesellschaftlichen Vorurteile wider, die in diesen Daten enthalten sind.

Fazit: Eine neue Ära der Sprach-KI

LLMs wie ChatGPT repräsentieren einen bedeutenden Fortschritt in der Entwicklung von Künstlicher Intelligenz. Sie bieten eine neue Form der Interaktion mit Maschinen, die in vielen Bereichen, von der Bildung bis zur Medizin, großes Potenzial zeigt. Gleichzeitig müssen wir die Grenzen dieser Technologie verstehen und die richtigen Rahmenbedingungen schaffen, um sie sicher und verantwortungsbewusst zu nutzen. Letztlich bleibt eines klar: LLMs sind keine perfekten Wissensmaschinen, sondern mächtige Werkzeuge, die uns helfen können, die Welt ein wenig besser zu verstehen – wenn wir lernen, ihre Eigenheiten richtig zu interpretieren.